Come apprende la tecnologia?

Un fattore rivoluzionario che si sta affermando nel campo delle tecnologie della percezione è la capacità sempre più abile delle macchine a riconoscere la realtà in cui vive l’essere umano.

I nuovi sensori digitali sono sempre più in grado di percepire e capire il significato di immagini e suoni: si tratta quindi di protesi intelligenti, in qualche caso più potenti dei sensi dell’uomo.

Ad esempio i sensori di prossimità dell’auto sono sempre più efficienti nel riconoscere pedoni, altri ostacoli, o pericoli che a volte gli occhi dell’uomo faticano a individuare.

Video Pubblicitario di Google che invita il pubblico a provare il suo prototipo di macchina senza guidatore nel 2014:

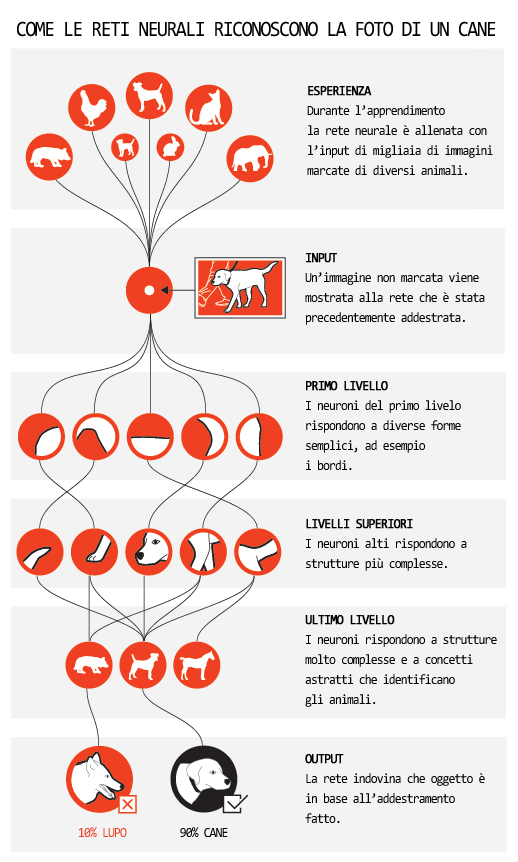

I due settori in cui il l’intelligenza artificiale (AI) si è evoluta più velocemente sono la computer vision e il riconoscimento vocale, due attività di pertinenza della percezione. L’attuale accelerazione delle tecnologie di riconoscimento delle immagini e della voce sono riconducibili all’aumento della potenza dei calcolatori e della mole di dati a disposizione in rete per l’apprendimento artificiale. Negli anni ’70 si inizia a sviluppare, almeno a livello teorico, una branca dell’informatica denominata “reti neurali”, in cui l’analogia con il cervello umano è il punto di partenza.

Il punto di partenza si basa sul fatto che l’apprendimento del cervello umano è guidato dall’esperienza. Nel software le reti neurali cercano di imitare questo apprendimento.

Se nel cervello umano i neuroni sono cellule nervose collegate tra loro che reagiscono a stimoli trasmettendo impulsi elettrici e fortificando le connessioni utili, nel software si cerca di fare altrettanto. I “neuroni” virtuali diventano dei sistemi che analizzano pochi dati in ingresso e restituiscono un solo valore in uscita, di solito una probabilità.

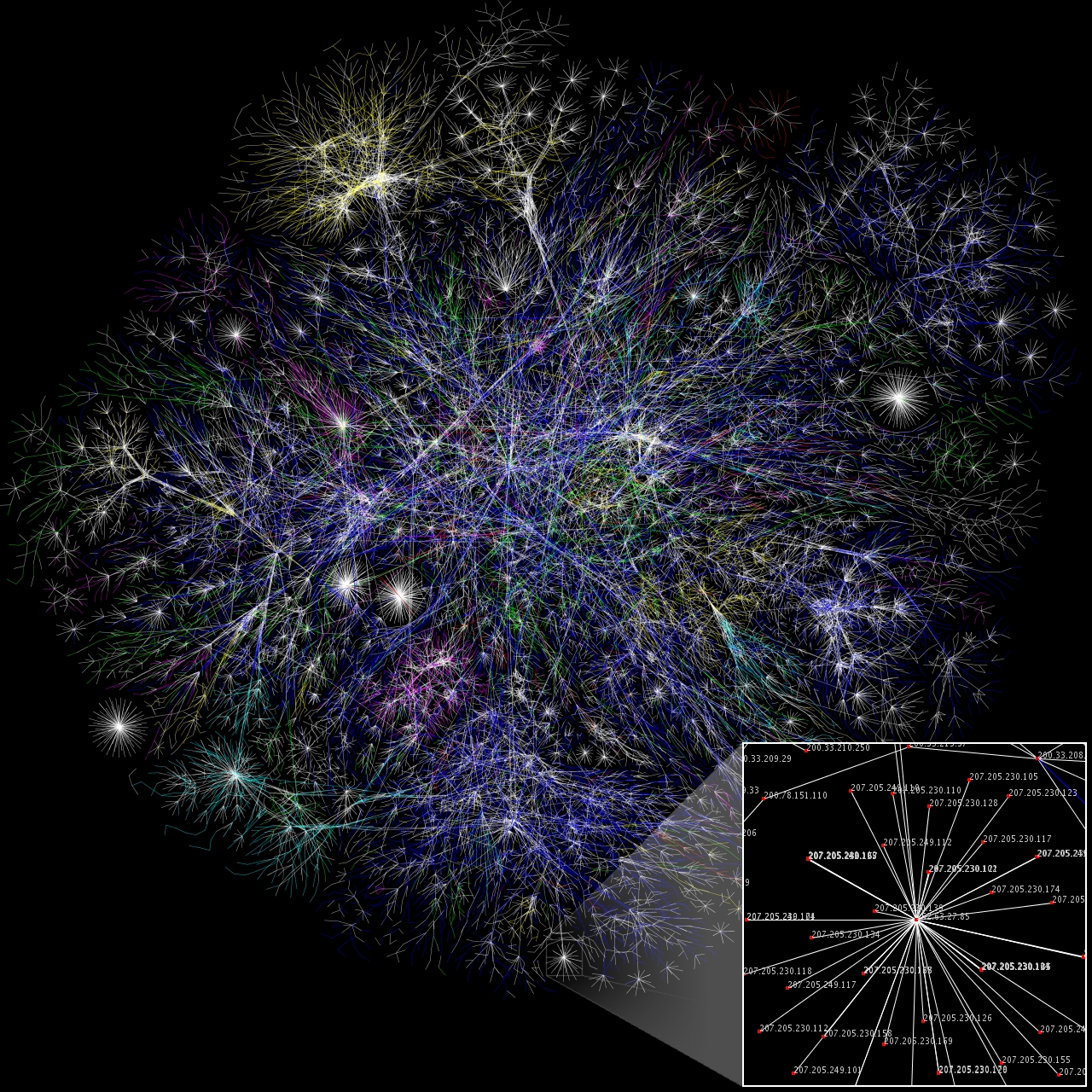

Però con solo uno o due neuroni software non si ottiene nulla, proprio come col cervello umano, che secondo alcune stime ne contiene 100 miliardi. Servono moltissimi neuroni e moltissimi dati. L’informatica ha preso i modelli e le scoperte della neuroscienza e ha copiato il funzionamento dei neuroni nei software. Per poi cercare i dati da elaborare nell’universo del web. Negli anni 90 i primi software per la dettatura vocale si doveva parlare piano e con voce impostata per riuscire a far scrivere al computer qualche parola giusta nel word processor. In sostanza erano inutilizzabili.

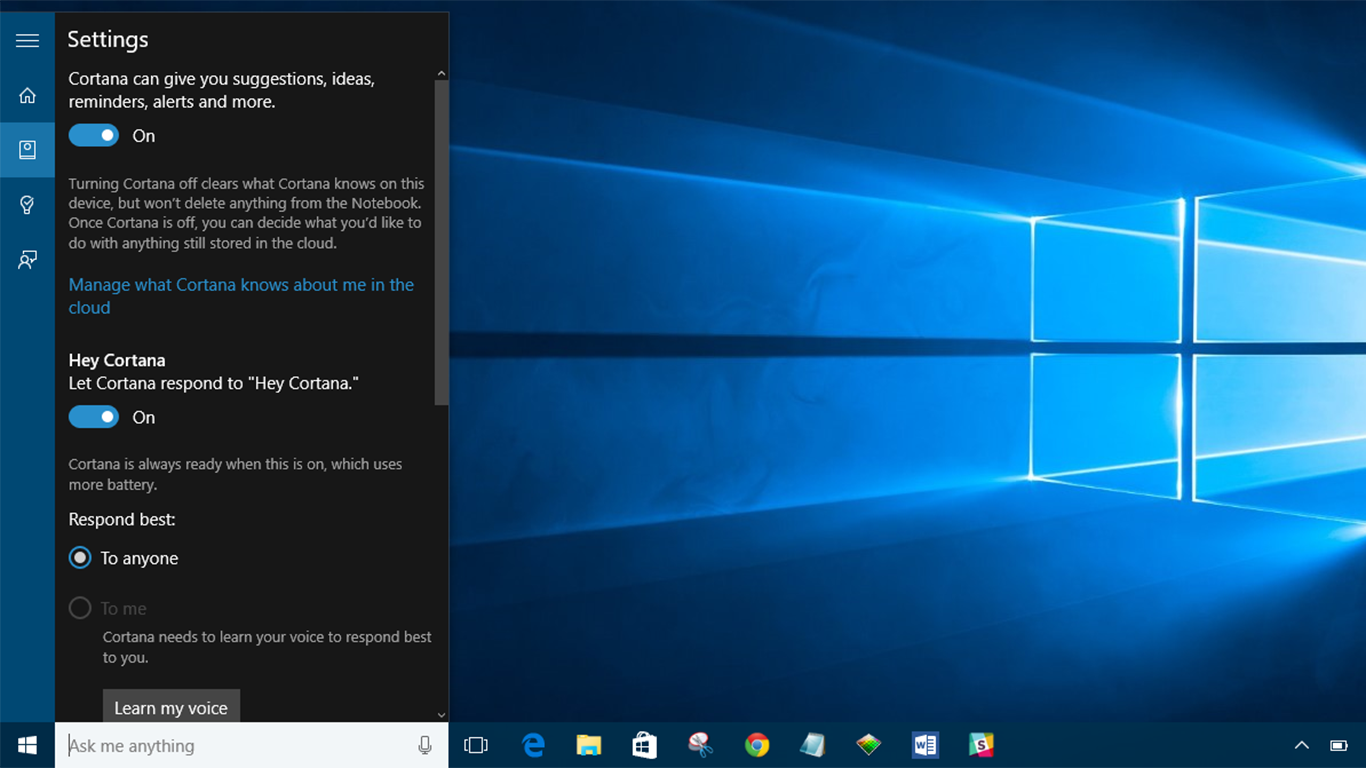

I risultati attuali (Siri di iPhone o la ricerca immagini di Google ad esempio), sono frutto di un passo in avanti successivo, reso possibile da due fattori: la maggiore potenza di calcolo dei microprocessori e la mole di dati utilizzabile.

Nell’addestramento dell’Intelligenza Artificiale in internet ogni volta che il risultato è corretto si aggiustano all’indietro tutti i parametri dei neuroni coinvolti in questo caso positivo, come se il web facesse “esperienza”. In questo modo la macchina apprende. Per fare un esempio comune, adesso Google, solo dai pixel di un’immagine, riesce a riconoscere se una foto contiene un cane, sia esso un mastino, un golden retriever, un dobermann, un carlino, escludendo gatti e lupi, e riesce a farlo anche se il cane è preso di spalle, se è parzialmente coperto, se c’è la nebbia o se l’immagine è capovolta.

La cosa che resta da fare con tanta potenza di calcolo e tanti dati è “insegnare alle macchine”, cioè costruire le reti neurali e provarle e riprovarle migliaia, se non milioni di volte e tarare quindi tutti i neuroni della rete per le risposte positive e provare con nuovi casi. L’attività più onerosa è insegnare alle macchine i casi “giusti”, ma nel momento in cui al programma si danno ad esempio migliaia di immagini di cani giuste, è il computer stesso che impara e trova i pattern che identificano il cane.

Abbiamo insegnato ai computer ad imparare.

Nell’immediato futuro possiamo aspettarci la diffusione di sensori intelligenti in grado di modificare radicalmente la relazione dell’uomo con la realtà circostante. L’uomo, ma anche un’auto, saranno dotati di una “supervista” in grado di riconoscere cose che l’occhio normale non riconosce, ad una velocità superiore, ad una distanza maggiore, identificando e comprendendo ciò che di circonda grazie a sensori ottici perennemente connessi ad internet…

Questa nuova capacità percettiva resa possibile da protesi digitali può essere definita una rivoluzione antropologica paragonabile alla scoperta del fuoco o della ruota.

Fonti: https://www.wired.it/ https://www.focus.it/ https://www.immersivevr.it/technology/